Tamaños de muestra y cálculos de velocidad, ¡Dios mío!

- Fernando Ferro

- 19 jun 2020

- 6 Min. de lectura

Traducción del inglés desde forensicphotoshop.blogspot.com aquí:

Publicado originalmente por Jim Hoerricks el Martes 18 de diciembre de 2018

Últimamente se ha hablado mucho sobre el uso de las imágenes de un DVR para determinar la velocidad de un objeto representado en el video. En mis clases sobre el tema, explico cómo configurar el experimento para validar los resultados de sus pruebas. En esta publicación, quiero presentar algunas instantáneas de los pasos en la validación.

Está bien documentado que los DVR no son cronógrafos suizos, son en su mayoría una caja barata de piezas aleatorias. Se ha demostrado que las marcas de tiempo en pantalla son "estimaciones" y "aproximaciones" de tiempo, no del todo confiables. También está bien documentado que los metadatos de los archivos contienen pistas sobre el tiempo. Echemos un vistazo a algunos escenarios.

Prueba 1: Geovisión

La pregunta en este caso era: ¿es confiable el elemento de evidencia particular en su generación de cuadros de modo que los metadatos de la velocidad de cuadros podrían usarse para el cálculo de la velocidad?

Se realizó un cálculo del tamaño de la muestra para ver cuántas pruebas tendrían que realizarse para construir un modelo del rendimiento del DVR. De esta manera, sabríamos si el elemento de evidencia era típico del rendimiento del DVR o un error único.

Análisis: A priori: Calcular el tamaño de muestra requerido

Entrada: Cola (s) = Uno

Proporción p2 = 0.8

α err prob = 0.05

Potencia (1- β err prob) = 0.99

Proporción p1 = 0.5

Salida: menor crítico N = 24.0000000

Crítico superior N = 24.0000000

Tamaño total de la muestra = 37

Potencia real = 0.9907227

Αctual α = 0.0494359

El cálculo determinó que un total de 37 pruebas (tamaño de muestra = 37) arrojaría los mejores resultados de muestra prueba binomial genérica (funciona correctamente / no funciona correctamente). En el otro extremo del gráfico, para un tamaño de muestra inferior a 10, un lanzamiento de moneda habría sido más preciso.

El análisis de cuadro que se muestra arriba, generado por Amped FIVE , parece indicar que la generación del cuadro I es bastante regular y quizás los cuadros P son duplicados del cuadro I anterior. Solo obtendría esta información de un análisis de los metadatos, más un hash de cada cuadro. Nada de lo que se ve en la pantalla o ver la reproducción del video le daría esta información específica.

Es importante tener en cuenta que este video representa un canal en un DVR de 16 canales. El DVR cuenta con activación por movimiento / alarma de sus grabaciones. Me llevó un poco de tiempo descubrir cuántas transmisiones de cámara estaban activas (movimiento / alarma) durante el tiempo en que se grababa el elemento de evidencia.

Con la información en mano, creamos un experimento para reproducir las condiciones de grabación originales.

Pero primero, se necesitan un par de definiciones importantes.

Datos de observación: es un estudio observacional en el que observan cosas en diferentes circunstancias sobre las cuales el investigador no tiene control.

Datos experimentales: son los datos que se recopilan de un estudio experimental que implica tomar medidas que se pueden controlar.

Nuestro experimento en este caso fue "experimental". Pudimos controlar qué canales de DVR estaban grabando activamente, cuándo y durante cuánto tiempo.

Con las 37 pruebas realizadas y los datos grabados, se determinó que la velocidad de grabación promedio dentro del DVR, para el canal que grabó el elemento de evidencia, era efectivamente siete segundos por cuadro. Esencialmente, el DVR estaba tan abrumado de datos que no podía procesar toda la señal entrante de manera efectiva. Hizo lo mejor que pudo, pero en su "estado de error", los fotogramas I se copiaron para llenar el contenedor de datos. Algunos I Frames eran incluso duplicados de I Frames anteriores. Esto probablemente se debió a una regla sobre los fps necesarios para crear el medio: el formato de contenedor nativo del sistema era .avi.

Datos de observación: es un estudio observacional en el que observan cosas en diferentes circunstancias sobre las cuales el investigador no tiene control.

Datos experimentales: son los datos que se recopilan de un estudio experimental que implica tomar medidas que se pueden controlar.

Nuestro experimento en este caso fue "experimental". Pudimos controlar qué canales de DVR estaban grabando activamente, cuándo y durante cuánto tiempo.

Con las 37 pruebas realizadas y los datos grabados, se determinó que la velocidad de grabación promedio dentro del DVR, para el canal que grabó el elemento de evidencia, era efectivamente siete segundos por cuadro. Esencialmente, el DVR estaba tan abrumado de datos que no podía procesar toda la señal entrante de manera efectiva. Hizo lo mejor que pudo, pero en su "estado de error", los fotogramas I se copiaron para llenar el contenedor de datos. Algunos I Frames eran incluso duplicados de I Frames anteriores. Esto probablemente se debió a una regla sobre los fps necesarios para crear el medio: el formato de contenedor nativo del sistema era .avi.

Prueba 2: Dahua

En una segunda prueba, se probó un DVR de caja negra "genérico". La mayoría de las partes podrían provenir de Dahua (China). El sistema de 16 cámaras genera un archivo nativo con una extensión .264.

Las "aplicaciones forenses", incluidas FIVE, están todas basadas en FFMPEG para la "conversión" de este tipo de archivos. Después de la conversión, el informe del procesamiento indicó que los fps del video de salida eran 25 fps. PERO, esto fue grabado en los Estados Unidos.

¿Es 25 fps la tasa correcta?

¿Es 25 fps un "estado de error"?

Si 25 fps no es la "velocidad correcta", ¿cuál debería ser?

En este caso, la información de velocidad de fotogramas en el contenedor original era "no estándar". Como tal, FFMPEG no tenía forma de identificar lo que "debería ser" y, por lo tanto, el valor predeterminado es 25 fps: el contenedor de salida necesita saber su velocidad de reproducción. ¿Por qué 25 fps? FFMPEG es francés, donde la velocidad de reproducción (PAL) es de 25 fps.

En este caso, no teníamos una marca de tiempo en pantalla para comenzar nuestro trabajo. Por lo tanto, necesitábamos realizar y experimentar para intentar calcular una velocidad de fotogramas efectiva para este DVR en particular. Esto comienza con un cálculo del tamaño de la muestra. ¿Cuántas pruebas necesitamos para construir el modelo de rendimiento del DVR?

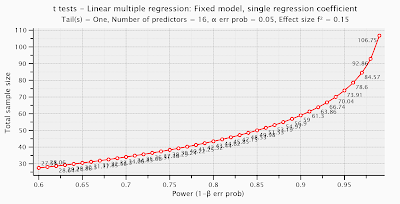

Pruebas t - Regresión múltiple lineal: modelo fijo, coeficiente de regresión simple

Análisis: A priori: Calcular el tamaño de muestra requerido

Entrada: Cola (s) = Uno

Tamaño del efecto f² = 0.15

α err prob = 0.05

Potencia (1- β err prob) = 0.99

Número de predictores = 2

Salida: parámetro de no centralidad δ = 4.0062451

Crítico t = 1.6596374

Df = 104

Tamaño total de la muestra = 107

Potencia real = 0.9902320

Para controlar todos los puntos de entrada de datos en el sistema (16 canales), así como los puntos de estrangulamiento de datos (chips y buses), nuestro tamaño de muestra ha aumentado significativamente. No es una simple prueba de sí / no como en la Prueba 1 (arriba).

Una regresión lineal múltiple intenta modelar la relación entre dos o más variables explicativas y una variable de respuesta ajustando una ecuación lineal a los datos observados. Básicamente, ¿cómo influyen los canales, buses y chips (variables independientes / de control) en el contenedor de datos resultante (variable dependiente)?

Se ejecutaron las pruebas y se reunieron los datos. Se encontró que la velocidad de fotogramas efectiva del canal que registró nuestra evidencia fue de 1.3526 fps. Si hubiera aceptado los 25 fps que le dio FFMPEG, la visualización del video habría sido inexacta. El uso de 25 fps para el cálculo de la velocidad también arrojaría resultados inexactos. Tener la velocidad de fotogramas efectiva, más la validación de los resultados, ayuda a que todo el proceso confíe en sus resultados.

Ciertamente ayuda que mi herramienta de elección para trabajar con los datos de video, Amped FIVE, contenga las herramientas necesarias para analizar los datos. Puedo hacer hash en cada cuadro (el hash ahora es parte de las Herramientas del Inspector en CINCO). Puedo analizar los metadatos (ver arriba). Además, puedo ajustar la velocidad de reproducción con precisión (cambiar el filtro de velocidad de fotogramas).

Estos ejemplos ilustran la clara diferencia entre lo que uno "sabe" y lo que uno puede "probar". Podemos "saber" lo que nos dice el flujo de datos a través de las diversas herramientas de análisis de cuadros disponibles. Podemos "probar" la validez de nuestros resultados mediante la realización de las pruebas apropiadas, utilizando la cantidad adecuada de pruebas (tamaño de muestra).

Si está interesado en saber más sobre este tema, o si necesita ayuda sobre un caso, o si desea aprender cómo hacer estas pruebas usted mismo, puede obtener más información haciendo clic aquí

Comentarios